Imagine acordar e descobrir que não consegue abrir o aplicativo do banco, o Zoom travou no meio da reunião mais importante do mês, seu filho está furioso porque o Fortnite não carrega, e até a Alexa virou um peso de papel caro na sua sala. Parece exagero? Pois foi exatamente isso que aconteceu em 20 de outubro de 2025 — e a culpada foi uma das empresas mais poderosas do planeta: a Amazon Web Services (AWS).

Mas como uma única empresa pode derrubar meio mundo digital ao mesmo tempo? E mais importante: o que isso revela sobre a fragilidade invisível da internet que usamos todos os dias?

Prepare-se, porque essa história tem reviravoltas técnicas, lições de bilhões de dólares e um alerta que todo mundo — de startups a gigantes — precisa ouvir.

O Dia em Que a Nuvem Desabou: O Que Realmente Aconteceu?

Um Bug Invisível com Efeito Devastador

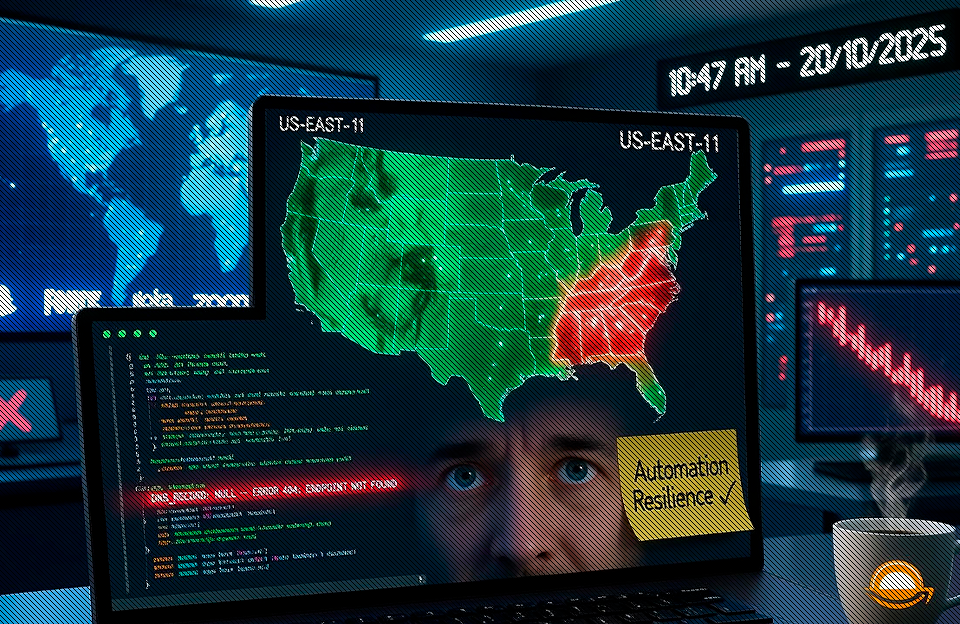

Na manhã de 20 de outubro, usuários ao redor do mundo começaram a reportar algo estranho: serviços aparentemente sem conexão uns com os outros pararam de funcionar simultaneamente. Snapchat, Fortnite, Zoom, Ring, Alexa — todos de joelhos. A princípio, parecia coincidência. Mas não era.

A AWS rapidamente confirmou: havia um problema sério na região US-EAST-1, localizada na Virgínia (EUA). Se você nunca ouviu falar dessa região, saiba que ela é como o coração do corpo digital global — uma das áreas mais críticas e movimentadas de toda a infraestrutura da AWS.

O vilão da história? Um bug no sistema automatizado de DNS usado para gerenciar os endpoints do DynamoDB, o banco de dados NoSQL da própria Amazon.

DNS: O Tradutor Invisível da Internet

Antes de prosseguir, vale explicar: DNS (Domain Name System) é como a lista telefônica da internet. Quando você digita “google.com”, o DNS traduz esse nome amigável para um endereço IP que os computadores entendem. Sem DNS funcionando, é como tentar ligar para alguém sem saber o número — simplesmente não rola.

No caso da AWS, o sistema criou um registro DNS vazio — essencialmente, um número de telefone que não leva a lugar nenhum. E o pior: a automação que deveria corrigir o problema automaticamente… falhou.

O Efeito Dominó: Quando Um Erro Derruba Milhares

A Cascata de Falhas

Aqui está onde a coisa fica realmente assustadora. O DynamoDB não é apenas “mais um serviço” — ele é usado por centenas de outros serviços dentro e fora da AWS. Quando ele ficou inacessível, aplicativos que dependiam dele (direta ou indiretamente) começaram a falhar em cadeia.

Pense assim: imagine que o fornecedor de energia da sua cidade falha. Não é só a luz que apaga — elevadores param, semáforos param de funcionar, computadores desligam, alarmes falham. Um problema localizado vira caos generalizado.

Foi exatamente isso que aconteceu digitalmente:

- Snapchat ficou fora do ar — milhões de conversas interrompidas

- Fortnite travou — jogadores perderam partidas e progressos

- Zoom instável — reuniões de trabalho viraram frustrações coletivas

- Alexa e Ring (produtos Amazon) ironicamente também caíram — a AWS derrubou a própria casa

Recuperação Lenta e Dolorosa

A AWS começou a trabalhar na solução imediatamente, mas a recuperação foi gradual. Às 18h01 (horário do leste dos EUA), a empresa declarou que “todos os serviços retornaram ao normal”. Mas a realidade no terreno foi diferente: muitos aplicativos demoraram horas para processar filas de requisições acumuladas, e alguns usuários relataram instabilidades até o dia seguinte.

A solução emergencial? Desativar temporariamente o sistema automatizado de DNS — basicamente, colocar o piloto automático no chão e assumir o controle manual enquanto corrigiam as proteções.

Por Que Isso Foi Tão Grave? (E Por Que Deveria Te Preocupar)

1. A Fragilidade dos Componentes “Básicos”

Sabe aquela expressão “quanto mais alto o cargo, maior a queda”? Na tecnologia, é o contrário: quanto mais básico o componente, maior o estrago quando falha.

DNS e bancos de dados são a fundação da internet moderna. Quando eles caem, tudo que está construído em cima desaba junto. É como descobrir que o alicerce do seu prédio está rachado — não importa quão bonito seja o apartamento.

2. US-EAST-1: O Calcanhar de Aquiles da AWS

A região US-EAST-1 não é apenas “mais uma” das dezenas de datacenters da AWS. Ela é historicamente a região mais antiga, mais usada e mais interconectada. Empresas do mundo inteiro têm serviços rodando lá — seja por comodidade, legado ou simplesmente porque foi o padrão inicial.

O problema? Concentração é o oposto de resiliência. Quanto mais gente depende de um único ponto, maior o impacto quando ele falha.

Comparação interessante: Imagine se todas as empresas do Brasil decidissem colocar seus escritórios em um único prédio em São Paulo. Eficiente? Talvez. Seguro? De jeito nenhum. Um incêndio e a economia para.

3. Quando a Automação se Volta Contra Você

Aqui está a ironia cruel: o bug aconteceu justamente no sistema que deveria prevenir bugs. A AWS usa automação pesada para detectar e corrigir problemas rapidamente. Na teoria, isso torna o sistema mais resiliente. Na prática, quando a própria automação falha, você tem um sistema que não apenas quebra — ele quebra sem saber que quebrou.

É como ter um alarme de incêndio que, em vez de tocar, começa a alimentar o fogo.

Lição de ouro aqui: Automação é poderosa, mas automação sem supervisão, redundância e guardrails é uma bomba-relógio. Até os robôs precisam de fiscais.

O Lado Positivo (Sim, Existe Um)

Transparência e Resposta Rápida

Ao contrário de algumas empresas que tentam varrer problemas para debaixo do tapete, a AWS foi relativamente transparente sobre o ocorrido. Publicaram updates constantes, explicaram a causa raiz e desativaram o sistema problemático para evitar recorrência.

Isso importa. Em um mundo onde confiança é moeda, admitir o erro e corrigi-lo rapidamente vale mais do que fingir perfeição.

Um Lembrete Necessário para Todos

Esse incidente serviu como um choque de realidade para empresas que colocam todos os ovos na mesma cesta. Muitas organizações perceberam, da pior forma possível, que precisam:

- Diversificar provedores (não depender só da AWS)

- Distribuir geograficamente (não concentrar tudo em US-EAST-1)

- Testar cenários de desastre (porque eles acontecem)

Dor é a melhor professora — e essa aula custou caro para muita gente.

O Lado Negativo (E as Perguntas Incômodas)

Quem Paga a Conta Quando a Nuvem Cai?

Aqui está o ponto mais controverso: até que ponto a AWS é responsável pelos prejuízos causados?

Pequenas startups perderam vendas. Empresas de e-commerce viram carrinhos abandonados. Profissionais perderam reuniões críticas. Gamers perderam campeonatos online. Alguém vai ressarcir essas perdas?

A resposta, na maioria dos casos, é não. Os contratos de serviço (SLAs) da AWS garantem créditos limitados em caso de indisponibilidade, mas esses valores são migalhas perto dos prejuízos reais. Uma startup que perdeu um dia de vendas durante Black Friday não vai recuperar isso com um vale de 10% de desconto no próximo mês.

Comparação com o mundo físico: Imagine se a companhia elétrica pudesse derrubar sua cidade inteira por 8 horas e a única compensação fosse: “Desculpa, aqui está um desconto na próxima conta”. Revoltante, certo? Mas é exatamente assim que funciona na nuvem.

A Ilusão da Redundância

Muitas empresas achavam que estavam “protegidas” porque tinham backups e sistemas de failover dentro da própria AWS. O problema? Se tudo está na mesma nuvem, você não tem redundância real — você tem ilusão de segurança.

É como ter dois cofres na mesma casa. Se a casa pega fogo, você perde os dois.

As 5 Lições Que Ninguém Pode Ignorar

1. Nunca Confie em Um Único Provedor

Não importa quão grande ou confiável seja a empresa. AWS, Google Cloud, Azure — todos podem falhar. A solução? Multi-cloud. Use diferentes provedores para diferentes partes do seu sistema.

Analogia simples: Você não guarda todo o seu dinheiro em um único banco, certo? (Se guarda, talvez devesse repensar isso também.)

2. US-EAST-1 Não É Obrigatória (E Talvez Nem Recomendada)

Muitas empresas usam US-EAST-1 por hábito ou desconhecimento. Existem outras regiões igualmente capazes e potencialmente mais estáveis.

Pense em dispersão geográfica não como custo extra, mas como seguro contra o caos.

3. Automação É Ferramenta, Não Solução Mágica

Sistemas automatizados são incríveis — até falharem. Sempre tenha supervisão humana, alarmes redundantes e planos de intervenção manual para quando o robô decidir que está tendo um dia ruim.

4. Teste Seus Cenários de Desastre (Antes do Desastre)

Quantas empresas realmente testam o que acontece se a AWS cair? Poucas. Simulações de caos (chaos engineering) não são luxo — são necessidade.

Se você não sabe como seu sistema se comporta quando tudo dá errado, você vai descobrir no pior momento possível.

5. Leia Seu Contrato de Nuvem (Especialmente a Parte Chata)

Você sabe o que seu SLA realmente cobre? Spoiler: provavelmente menos do que você imagina. Entender as limitações contratuais ajuda a planejar seguros e estratégias de mitigação realistas.

O Debate Mais Profundo: Concentração de Poder Digital

Aqui está uma reflexão que vai além da tecnologia: o incidente da AWS expõe um problema muito maior — a concentração absurda de poder em pouquíssimas empresas.

AWS, Google Cloud e Microsoft Azure controlam mais de 60% de toda a infraestrutura de nuvem do planeta. Quando uma delas falha, uma parcela gigantesca da economia global paralisa.

É saudável ter tanta dependência assim? A resposta é: não, se houver barreiras artificiais à competição. O ideal seria um ecossistema com mais competidores viáveis, mais opções reais e menos concentração de risco.

Mas o mercado de nuvem tem enormes barreiras de entrada — infraestrutura cara, expertise complexa, economias de escala brutais. Isso cria um oligopólio natural que, embora eficiente em muitos aspectos, é perigosamente frágil quando algo dá errado.

A pergunta que ninguém quer fazer: Estamos confortáveis vivendo em um mundo onde três empresas podem, sem querer, desligar metade da internet?

Conclusão: Nuvem Sim, Mas Com os Pés no Chão

O apagão da AWS de outubro de 2025 não foi o primeiro (e certamente não será o último) a nos lembrar de uma verdade inconveniente: a nuvem é maravilhosa, mas não é infalível.

A lição não é abandonar a nuvem — seria como desistir de eletricidade porque ocorrem blackouts. A lição é ser estratégico, diversificado e realista sobre riscos.

Para empresas: distribuam, testem, planejem.

Para usuários: entendam que a conveniência tem seu preço — e às vezes esse preço é ficar offline por algumas horas.

No final das contas, a AWS nos ensinou que até gigantes podem tropeçar. E quando gigantes caem, o tremor é sentido no mundo inteiro.